Consideraciones de seguridad al usar ChatGPT

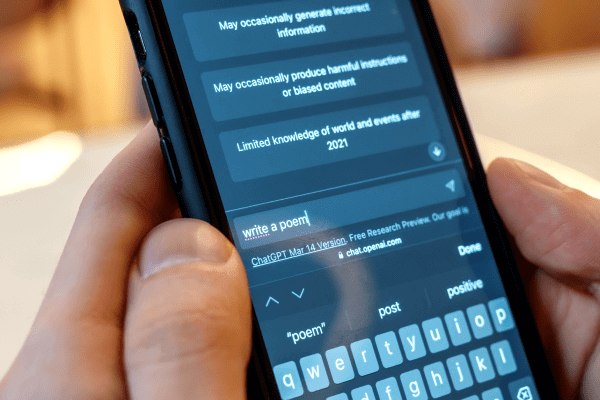

La creciente adopción de herramientas de inteligencia artificial como ChatGPT para trabajos relacionados con comunicación y Relaciones Públicas de las marcas, está revolucionando la rapidez con la que se puede desarrollar materiales editoriales e informativos. Sin embargo, esta innovación plantea importantes interrogantes sobre la privacidad y seguridad de los datos sensibles de de las empresas, es por eso que, antes de usar esta herramienta, es importante que tomes en consideración los siguientes aspectos:

La importancia de la confidencialidad de los datos:

Salvaguardar la información sensible de una marca debe ser una prioridad absoluta para cualquier comunicador. La filtración de información estratégica, como planes de comunicación, mensajes clave o estrategias internas, puede tener consecuencias graves en la reputación de una marca.

Es crucial establecer políticas claras para el manejo de la información y garantizar que se cumplan estrictamente. Además, es fundamental firmar acuerdos de confidencialidad sólidos con todas las partes involucradas, asegurando así la seguridad de los datos y evitando revelaciones no autorizadas.

Lo que debes saber sobre las políticas de Seguridad de ChatGPT y OpenAi:

Es imprescindible revisar detenidamente la política de privacidad y los términos de servicio de ChatGPT proporcionados por OpenAI. Según su Política de Privacidad, la herramienta recopila información de tres fuentes: la información de la cuenta, la información ingresada en el chat y los datos extraídos del dispositivo o navegador del usuario. OpenAI almacena y utiliza esta información con el objetivo de mejorar el sistema y ofrecer un mejor servicio a los usuarios, y también lo puede compartir con terceros.

También se menciona en su política qué OpenAI comparte la información personal de los usuarios con vendedores, proveedores de servicios, otras actividades empresariales, subsidiarias, entidades legales y entrenadores de IA que revisan las conversaciones para mejorar el chat. Lo que representa una gran cantidad de frentes antes los cuales la información de sus clientes, será expuesta.

Es fundamental comprender con quién se comparten los datos y bajo qué circunstancias para evaluar el nivel de confidencialidad y seguridad ofrecido por la herramienta.

Entonces, ¿nos abstenemos de su uso?

Podemos confiar en las buenas intenciones de las empresas de IA a las que otorgamos información, o aún mejor, implementar medidas para reducir el riesgo de posibles filtraciones de datos.

Antes de lanzarnos de cabeza a la era de la Inteligencia Artificial se deben generar políticas claras dentro de las empresas que brindan servicio de comunicación y RRPP sobre el uso seguro de herramientas tales como Chat GPT. Estas pueden incluir:

- Limitar el acceso a datos sensibles: Si es posible, evita compartir información altamente sensible con ChatGPT o cualquier herramienta de IA. Reduce al mínimo la cantidad de datos confidenciales que se ingresan o se comparten a través del chatbot.

- Anonimizar datos sensibles: Antes de utilizar ChatGPT, considera anonimizar los datos sensibles. Elimina o enmascara los nombres de marcas o clientes específicos al interactuar con la herramienta.

- Monitoreo y revisión continua: Establece un proceso de monitoreo y revisión regular de la seguridad y el uso de ChatGPT. Supervisa las interacciones y los datos que se comparten para identificar cualquier actividad sospechosa o inusual.

- Información mínima necesaria: Al utilizar ChatGPT, proporciona sólo la información mínima necesaria para realizar la tarea requerida. Evita revelar información adicional o innecesaria que pueda ser sensible.

- Investigación y seguimiento de actualizaciones de seguridad: Mantente informado sobre las actualizaciones de seguridad y las mejores prácticas recomendadas por OpenAI y otros expertos en IA. Sigue las recomendaciones y las medidas de seguridad adicionales que puedan proporcionar para proteger la información sensible.

Estas medidas adicionales fortalecen aún más la seguridad de los datos y brindan una capa adicional de protección a la información sensible de los clientes.

Chat GPT no es el enemigo

En la actualidad la mayor parte de nuestro trabajo se desarrolla en línea, en este sentido no solo debemos cuidarnos de la exposición de datos en Chat GPT o similares, otras herramientas en línea como Google Workspace, Microsoft Teams o el mismo Whatsapp, también implican riesgos de seguridad en cuanto a la protección de datos sensibles. ya que estas plataformas manejan y almacenan información confidencial de sus usuarios, como documentos, correos electrónicos, chats y archivos compartidos.

Muchas veces estos riesgos están más relacionados con el error humano que con violaciones de seguridad o accesos no autorizados a las herramientas.

Es importante tener en cuenta que estos proveedores de servicios en la nube suelen implementar medidas de seguridad robustas para proteger los datos de sus usuarios. Sin embargo, no se puede descartar completamente el riesgo de violaciones de seguridad o accesos no autorizados.

La seguridad de los datos debe ser una prioridad constante, tanto en el uso de Chat GPT como en otras herramientas y plataformas utilizadas por profesionales de la comunicación.